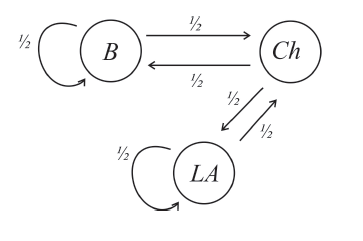

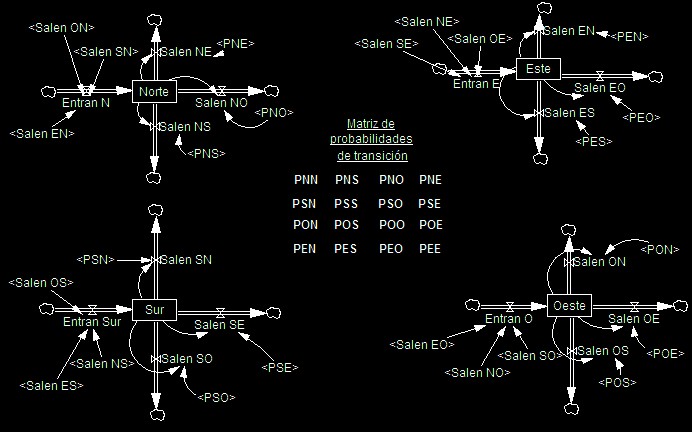

Ejercicios Resueltos DE Cadenas DE Marko - EJERCICIOS RESUELTOS DE CADENAS DE MARKOV En un pueblo, - Studocu

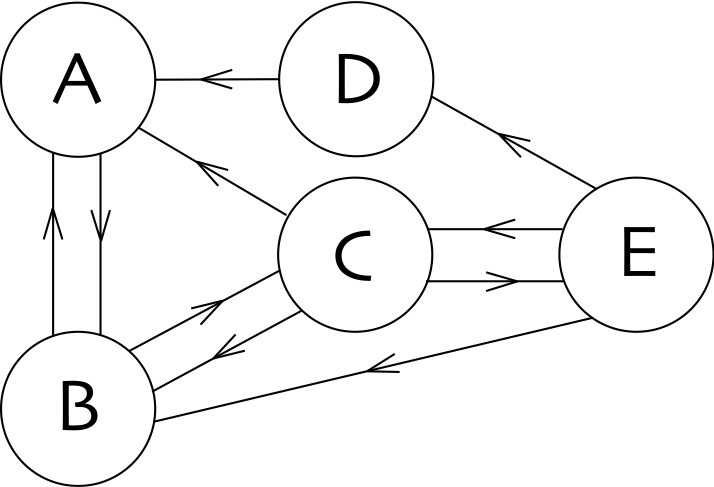

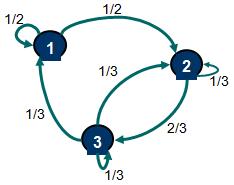

Clasificación de estados de una Cadena de Markov - Definición de cadena irreducible, estados recurrentes, transcientes, periódicos y aperiódicos